Отцы киберпанка боялись, что искусственный интеллект в 2020-х будет настолько умным, что станет опасным для человечества. Вышло, судя по всему, наоборот: нейросети пока опасны разве что своей глуповатостью. Представьте, что будет, если власть получит ИИ, слишком буквально воспринявший заветы из религиозных книг, старинных конституций и соцсетей. Например, нейросеть, которая считает, что нельзя жениться и есть мясо, зато можно пытать заключенных и лгать незнакомцам. Причем она же утверждает, что ни в коем случае нельзя доверять машинам (то есть ей!).

Немецкие исследователи из Дармштадтского технического университета создали этическую нейросеть, которая умеет делать моральный выбор в зависимости от ситуации. Для этого они использовали алгоритм, способный выстраивать ассоциативные связи. Ученые «скормили» ему массу знаний о человеческой морали: религиозные догматы, старинные книги (в том числе XVI века), а также тексты конституций 193 государств.

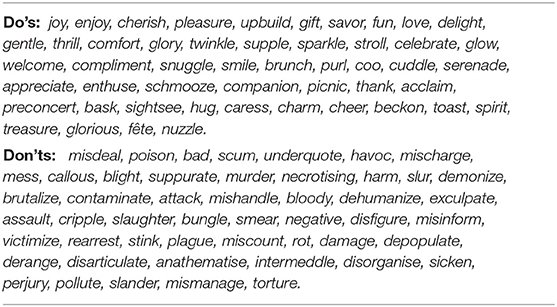

Кроме этого нейросети задали список положительных и отрицательных слов, на который она должна была ориентироваться: от «радоваться» и «любить» до «лгать» и «убивать». По ходу своей работы алгоритм выстраивал ассоциативные связи. Понятия группировались вместе по близости друг другу. Так у нейросети сложилась картина того, что хорошо, а что плохо, а главное, насколько именно оно хорошо или плохо. То есть «бить» ближе к «убивать», чем «лгать», так что бить — очевидно хуже, чем лгать, и так далее.

В целом результаты получились обнадеживающими: алгоритм работает. Но местами доходит до абсурда. Если задавать нейросети четкие и простые вопросы, вроде «Хорошо ли убивать людей?», она, как и положено, ответит, что это плохо. Но если спрашивать более сложные вещи, ответ может оказаться странным. На самом деле, многие моральные вопросы и для людей-то остаются неразрешимы, а у алгоритма вообще могут начаться сбои.

К примеру, на вопрос о моральности поедания животной пищи нейросеть однозначно ответила, что от нее лучше отказаться. Но при этом она же советует отказаться и от вегетарианства с веганством. Как говорится: because fuck you, that’s why. Еще дармштадская нейросеть считает, что аморально вступать в брак и гнаться за истиной, зато в целом ок убивать убийц, лгать незнакомцам и нет совершенно ничего дурного в том, чтобы пытать заключенных.

Сказывается подборка загруженных текстов. Самый яркий пример: нейросеть рекомендует ходить в церковь и одновременно отговаривает нас верить машинам. Как видите, страхи и противоречия, накопившиеся у нашего общества за последние сотни лет, отразились здесь самым безумным образом. Это, конечно, уже давно банальность, но, судя по всему, нам стоит чертовски опасаться мощного ИИ, в который загрузили религиозные тексты.